ゲス顔イオナズン

Stable Diffusion✕AIイラスト徹底解説!

【ControlNet革命】「Segmentation」で構図を支配しよう!こんばんは、スタジオ真榊です。このところAIと著作権をめぐる投稿が続いてしまったので、しばらくは本題に戻って、いつものStableDiffusionを使ったAIイラスト術について紹介していきたいと思います。今回はControlnet機能の一つ「Segmentation」の活用法についてです!

「ControlNet徹底解説!プロンプト苦難の時代が終わる…」でControlNetの各種機能については解説したところなのですが、前回は「Segmentation」だけ賢木の環境にうまく導入できず、説明を飛ばしてしまったんですよね。その後無事に活用できるようになったのですが、使えば使うほどに「Segmentationこそが構図を支配する聖杯…!」との思いを強くしたので、今回はじっくりその実力を確かめていきたいと思います。

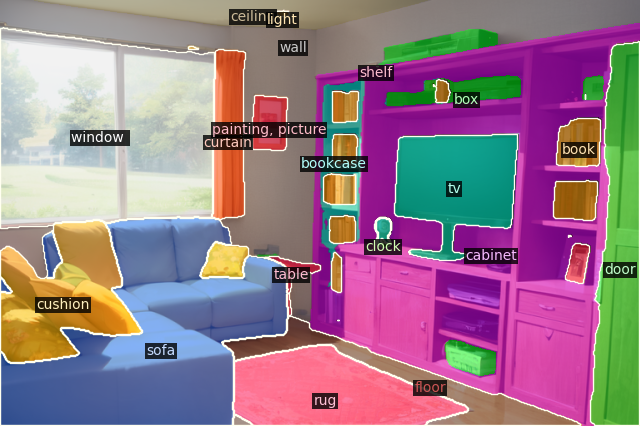

Segmentationを導入しよう!さて、まずは前回のおさらいから。ControlNetは参考画像をもとにさまざまな情報を抽出して、それをもとに新たな絵を生成してもらうi2iの進化版のような機能でした。「Canny」は輪郭抽出、「Openpose」はボーン抽出、「Depth」は深度情報抽出、「Scribble」でラフ読み込み、「Fake scribble」はcannyよりおおまかな輪郭抽出…などなどが前回紹介した機能でしたが、今回紹介する「Segmentation」はこちらの画像のように、画面上のどこに何が描かれているかを自動認識して色分け指定する画期的な機能です!

▼導入方法

前回説明したのと同様、ControlNet-modules-safetensorsから「control_seg-fp16.safetensors」をダウンロードし、「stable-diffusion-webui\extensions\sd-webui-controlnet\models」フォルダに放り込めばOK。Controlnetの画面上で適当な画像を読み込ませ、Enableをオン、preprosessorを「segmentation」、モデルを「control_seg-fp16」にして画像生成してみましょう。他の学習セットと同様、初回生成時だけ読み込みに時間が掛かりますが、上の「塗り絵」のような画像が表示されれば成功です。

※うまくいかないときはcontrolnetをアップデートしてみましょう。初めてsegmentationを使う際、初回の画像生成前に「preview annotator result」ボタンを押すとエラー表示になるかもしれません。構わず一度画像生成してみてください。 【注意喚起】使用モデルのライセンスを再確認しよう!こんばんは、スタジオ真榊です。今日は学習モデルのライセンスをめぐって界隈がちょっとざわついた件をめぐる、「もう一回自分の使っているモデルのライセンスを確かめてみよう!」という注意喚起系の記事です。

このたび「ChilloutMIX」というフォトリアル系の人気モデルのライセンス表記が急に変更となったのですが、このモデルは先日レビュー記事でもご紹介したAbyssOrangeMix3にもマージ(混合)されており、派生モデルにも当然それが影響します。改めてそれぞれのモデルで何ができて、何ができないのかを確認したいと思います。 AI術師が知っておきたい著作権の話▼「イラスト無断転載事件」で考えるこんにちは、スタジオ真榊です。今回はStable diffusionの技術関連のお話ではなく、AIイラストの著作権とその侵害について、ツイッター上で起きた無断転載トラブルを振り返りながら考察したいと思います。

AI生成物の権利については、昨年11月に公式ブログの「【NovelAI】「生成イラストの権利は誰のもの?」徹底検証」でも紹介したところですが、その後ローカル環境での生成を多くのユーザーが楽しむようになり、さらにLoRAやControlnetといった全く新しい技術も浸透してきました。AIイラストを取り巻く状況はどんどん変化していますので、改めて2023年2月現在の状況を概観できればと思います。

(※本稿はAI術師界隈の司法関係者の方に監修していただきました) 【OpenPose Editor導入】もっと自由にポーズをつけよう!(ControlNet解説)こんばんは、スタジオ真榊です!

ControlNet、してますか?毎晩寝不足な日々が続いていますが、今夜は前回の「ControlNet徹底解説!プロンプト苦難の時代が終わる…」に続き、具体的なポーズの付け方についての実践編です。

ControlNet公開以来、特にキャラクターのボーン(骨組み)でポーズ指定できるOpenposeをより自由に設定する方法が次々に考案され、拡張機能としても登場しています。今回はそれらを使って、さまざまなポージングの可能性を探っていければなと思います。よろしくお願いいたします! 実験概要今回はスレッタちゃんに例のポーズを取ってもらう実験をしてみます。

プロンプトではほぼどう指定したものだか困ってしまう、例のポーズ…。ただ、Cannyやopenpose handを使ってこの輪郭をぶっこ抜くのは公式のi2iパクリとほぼ同じなので、それ以外の方法を使って再現するにはどうするのがよいか、実践していきたいと思います。

【@studiomasakaki】ツイッター投稿まとめ主なツイッター投稿やイラストです。フォローしておくといいことあるかも? 5000フォロワーありがとうございますわ~!毎日こんな楽しくて良いのかしら! pic.twitter.com/1WMmWhvWDr— 賢木イオ@スタジオ真榊 (@studiomasakaki) February 19, 2023 最適設定を探せ!「AbyssOrangeMix3」最速レビューこんばんは、スタジオ真榊です。本日、賢木も愛用している「AbyssOrangeMix」の最新バージョン、「AOM3」が公開されました!カワイイ、アーティスティック、そして遠慮のないエロと三拍子そろったAOM2は層別マージモデルの傑作だったわけですが、その進化形となる「AOM3」は一体どんなモデルなのか?さっそくレビューしたいと思います。 しかし、この界隈本当に進化のスピードが速すぎる!やることが…やることが多い…! 目次 AbyssOrangeMix2の振り返り 注意!AOM3は2/25現在、2と異なり生成画像の商用利用などが禁止されています。利用の際はこちらの記事「【注意喚起】使用モデルのライセンスを再確認しよう!」をご覧いただき、ライセンス表記をもう一度確認することをおすすめ致します。 【導入方法】ControlNet徹底解説!プロンプト苦難の時代が終わる…こんにちは、スタジオ真榊です。ここ数日はこの話題でもちきりですね。そう、拡張機能「ControlNet」の衝撃的デビューで、プロンプトやi2iでポーズや構図をなんとか表現しようと苦心していた時代は過去のものになりました。

Controlnetは、参照画像からキャラクターの四肢のボーンやイラストの主線、depth(深度情報)などさまざまな情報を抽出し、イラストのポーズや構図を自由に制御できる革新的な拡張機能です。2023年2月10日に論文が投稿されるや、わずか数日でStable Diffusion用WebUI向けの拡張機能が登場。当初は1つ5GB超えのモデルを8つダウンロードしなくてはなりませんでしたが、あっという間に一つ約700MB程度に圧縮され、容易に導入できるようになってしまいました。

単に構図やポーズを指定するだけでなく、イラストの主線や輪郭を保存して新たにイラストを生成しなおすことすら可能になったため、線画の着色やマウスで描いた落書きからのいきなり完成イラスト生成といったi2iではできなかったことが次々にできるようになっています。まさに革命!

さっそく今回は導入方法の解説とともに、各学習モデルの違いや使い方を解説していきたいと思います。 【この記事はFANBOX会員向け記事ですが、前半部分を無料公開します】

|

|

copyright © 2023 ゲス顔イオナズン all rights reserved.