ゲス顔イオナズン

Stable Diffusion✕AIイラスト徹底解説!

Controlnetが理解る!モデル15種&プリプロセッサ35種を徹底解説★FANBOX記事の前半部分までを無料公開しています こんばんは、スタジオ真榊です。今回はStableDiffusionwebUIに大きな革命をもたらした拡張機能群「Controlnet」の大型解説記事です。2023年春に登場した「ver1.1」について、2023年4月27日時点で使用できるモデル14種とプリプロセッサ全35種のそれぞれの特徴とできることを検証しました。

Controlnetには、線画だけを抽出できる「Lineart」やポーズだけを抽出できる「Openpose」といったさまざまなモデルがあり、それらを有効に動かすための下ごしらえをする「プリプロセッサ(前処理機能)」というものが用意されています。

今回の記事は、それぞれの組み合わせやパラメータ設定、それによってできることなどを詳しく解説していく「総論」的な解説。「各論」に当たる各モデルの詳しい検証記事もリンクしてありますので、ぜひご活用ください。 目次インストール&アップデート方法 新モデル「inpaint」でイラストの続きを描いてもらおう!【Controlnet1.1検証】こんばんは、スタジオ真榊です。前回の「Pix2pixでイラストを変化!10種の実験で分かったこと」に引き続き、今回もControlnet1.1でできることを検証していきます。

今回紹介するのは、新モデル「inpaint」。これはその名の通り、マスクした部分を描き直すインペイント機能に特化したControlnetモデルです。とはいえ「image2image画面で通常のインペイントをするのとどう違うの?」というのが最初に覚える疑問。text2textの画面でどうやってインペイントすればいいのかも含め、何ができるようになったのかを検証していきましょう。

なお、この記事では、img2imgタブで利用する従来のinpaint機能を「i2iインペイント」、今回検証するcontrolnet1.1のモデルとしてのinpaintを「inpaintモデル」と呼んで区別することにします。 目次実験:髪色を変化させる 実験:服装を変化させる 実験:表情変化を試す

実験:崩壊した手を直せる?

実験:イラストの一部を消して置き換える

実験:続きを描いてもらう「outpaint」

「Pix2pix」でイラストを変化!10種の実験で分かったこと【Controlnet1.1検証】こんにちは、スタジオ真榊です。前回の記事に引き続き、今夜もControlnet1.1の新モデル検証の続きをお届けしたいと思います。

今回検証するのは「Pix2pix」。前回はイラストの要素をばらばらにして再構成する「Shuffle」について研究しましたが、Pix2pixは再構成ではなく「変化」を扱う新技術です。Controlnetのアップデートに注意しながら、さっそく見ていきましょう。

目次

・元イラストを変化させられる「Pix2pix」 ※今回の検証には一部、着衣状態の女の子を脱衣させる実験が含まれます。ご注意ください。

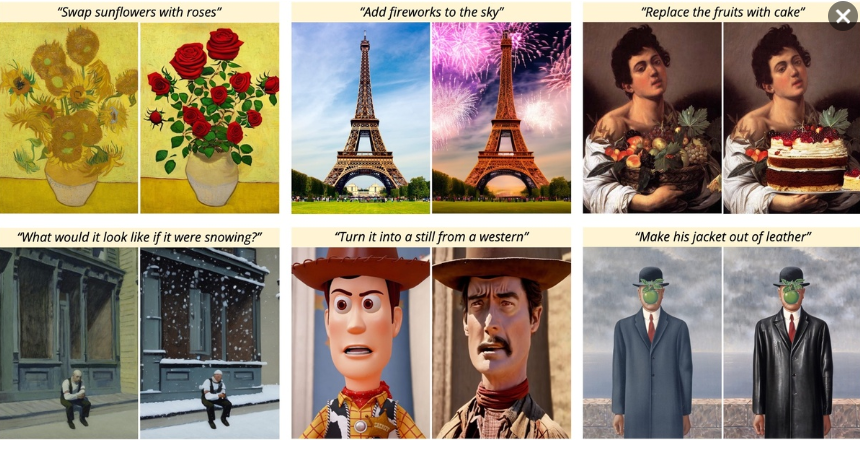

元イラストを変化させられる「Pix2pix」Pix2pixは「ペア」になった画像を教師データとして大量学習させることで、AIに二つの画像の間の「関係性」を覚えさせ、ある入力画像を渡すと指示通りに変化させて出力させられるようにする技術のこと。例えば、赤いリンゴの絵と青いリンゴの絵をペアで学習したAIは「Aを青くしたものがB」という関係性を学びますので、「このイチゴを青くして」という要求に応えられるようになる・・・というわけです。

こちらの例では、「ひまわりをバラに取り替える」「空に花火を加える」「果物をケーキに置き換える」といった指示プロンプトによって、その通りに画像が変化していることが分かります。

「ある画像を入力して別の画像に変換する」という意味ではShuffleに似ていますが、Shuffleがあくまで元画像をピースとしてパズルをくみ上げる「再構成」のイメージなのに対して、Pix2pixはあるお題を任意の状態に「変化」させるイメージ。Shuffleと違って元イラストの色合いや要素を必ずしも継承しないので、入力画像と出力画像の雰囲気が似ないこともありますし、変化させる対象(上の例なら花や空、コートなど)を限定して置き換えることもできます。

【Controlnet1.1検証】新モデル「Shuffle」でイラストを"再構成"しよう!はいこんばんは、スタジオ真榊です。前回の「Controlnet1.1爆誕!顔抽出&アニメ主線抽出&線画塗りを試してみた」に引き続き、今回もControlonet1.1の検証記事をお届けします。

これから検証するのは、「Shuffle」「Pix2Pix」「Inpaint」の新顔3種モデル。前回紹介した「新Openpose」と「LineartAnime」はControlnet1.0でもできたことの進化版という印象でしたが、新3種モデルはそれぞれ全く新しい概念をStableDiffusionに持ち込むモデルとなっています。

具体的には、

・「元画像を構成する要素を"シャッフル"して、全く異なる構図のイラストとして再構成する」(shuffle)

・「この画像をこう変化させてとAIに頼む」(pix2pix)

・「これまでのinpaint機能より正確な『描き直し』をする」(inpaint)

・・・ことが可能になります。

『何を言っているのかわからねーと思うが、おれも何をされたのかわからなかった…』状態に陥りますが、どれも直感的に分かりやすく、かつ画期的な機能。1記事に3種の検証結果はおさまりきらなかったので、まずは「Shuffle」から順番に見ていきましょう! Controlnet1.1爆誕!顔抽出&アニメ主線抽出&線画塗りを試してみたこんばんは、スタジオ真榊です。AIイラスト術天下一武道会の開催真っ最中ですが、Controlnet1.1がSDwebUIの拡張機能にぃ… きたー!!! というわけで、既に午前2時なのでかなり限定的な内容にはなりますが、前置きは全てすっ飛ばして最速でアプデ方法と注意点、使用感をお伝えしていきます。Check it out! 『AIイラスト術 天下一武道会』開催中!AIイラスト活用術についての有益記事が集まるスタジオ真榊初のイベント、『AIイラスト術 天下一武道会』を開催中です!エントリー作品はこちらの10作品。投票で最も支持を集めた優勝者には、AI術師界隈で最も人気を集めているグラフィックボード「GeForceRTX3060(VRAM12GB)」、もしくは3万円分のアマゾンギフト券が進呈される豪華イベントとなっております! エントリー作品は4月15日以降、毎日20時にFANBOXに更新されますので、みなさまぜひ御覧ください!10作品公開後は、FANBOX支援者の皆様による優勝予想ダービーを開催。優勝者を当てた方から抽選で1名様に、これまでの支援金と同額のアマゾンギフトカードが進呈されます!そちらもぜひお楽しみに~! Twitterのアルゴリズム判明!実験したらえらいことになった話こんばんは、スタジオ真榊です。前回はシャドウバンについて考察しましたが、本日もAI術師さん向けTwitter攻略術の続きということで、2023年3月31日にGithub上で公開されたツイートのおすすめアルゴリズムについての記事をお届けします。

公開されたソースコードを見た人たちからは、例えば「ツイート拡散の観点において、リプライは『いいね』の27倍の価値がある」とか「フォローしている人数がフォロワー人数より多いアカウントの投稿は拡散されにくくなる」といった情報が次々に投稿され、話題になっています。ただ、ソースコードをよく見てみると、どうも我々の投稿は、ちまたでよく言われているものとはちょっと違う仕組みで採点されていることがわかってきました。

そこで、いつもの実験を行うことにしました。「公開された情報を参考にしたら実際にバズることはできるのか?」ということで、非フォロワーに拡散されやすくなるという要素を研究し、全部盛りにしたツイートをしてみた結果がこちらです。 スタジオ真榊のアカウントでは、いきなり過去最も拡散されたツイートになってしまいました。あからさまに拡散を狙いに行ったツイートだったのでなかなか書いていて恥ずかしかったのですが、予想以上の結果だ…

そんなわけで、今回はアルゴリズムの内容を分かりやすく解説しながら、あくまでAI術師の観点から「どうしたら多くの人のTLに自分のAIイラスト投稿を表示できるのか?」または「なぜ自分のAIイラストはツイッターに拡散してもらえないのか?」ということを考える記事にしていきたいと思います。今回も長くなりますが、どうぞおつきあい下さい。 |

|

copyright © 2023 ゲス顔イオナズン all rights reserved.